Dies ist der zweite Teil einer vierteiligen Blogserie, die sich mit dem weltweiten Vermittlerhaftungsrecht befasst. Weitere Beiträge können Sie hier lesen:

- Trends in der Plattformhaftung rund um den Globus: Von sicheren Häfen zu erhöhter Verantwortung

- Plattformhaftungstrends rund um den Globus: Jüngste bemerkenswerte Entwicklungen

Das Geflecht der globalen Gesetze zur Vermittlerhaftung wird immer umfangreicher und komplexer, da die politischen Entscheidungsträger*innen auf der ganzen Welt strengere rechtliche Rahmenbedingungen für die Regulierung von Plattformen einführen wollen. Um die Dinge zu entwirren, bieten wir einen Überblick über die verschiedenen Ansätze zur Vermittlerhaftung. Außerdem stellen wir eine Version des Werkzeugkastens zur Vermittlerhaftung von Daphne Keller vor, der die typischen Bestandteile eines Vermittlerhaftungsgesetzes sowie die verschiedenen Regulierungsstellschrauben enthält, mit denen die Gesetzgebenden die Wirkung des Gesetzes kalibrieren können.

Das Spektrum der Intermediärhaftung

Die Haftung selbst kann auf der Grundlage der Strafe unterschieden werden: monetäre und nicht-monetäre Haftung. Die monetäre Haftung führt dazu, dass den Klagenden Schadenersatz zugesprochen wird, während die nichtmonetäre Haftung dazu führt, dass Vermittelnde verpflichtet werden, Maßnahmen gegen rechtswidrige Handlungen zu ergreifen, die durch die Inanspruchnahme ihrer Dienste begangen wurden (in der Regel in Form von Unterlassungsverfügungen).

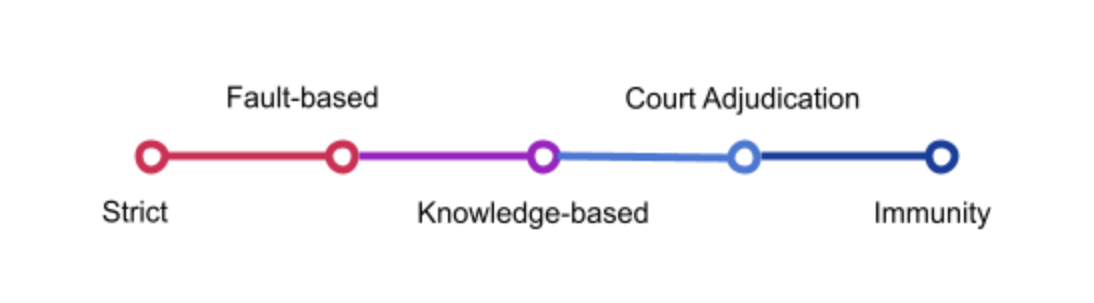

Finanzielle Entschädigungen werden nach Feststellung der Haftung der Vermittelnden gewährt, die von verschuldensabhängiger, wissensbasierter und gerichtlich entschiedener Haftung bis hin zu völliger Immunität reicht. Verschiedene Konfigurationen entlang dieses Spektrums tauchen immer wieder auf, da die Regulierungsbehörden mit verschiedenen Stellschrauben experimentieren, um Rechtsvorschriften zu schaffen, die auf bestimmte Kontexte zugeschnitten sind.

Die in diesem Abschnitt vorgestellten Kategorien sind als allgemeine Konzepte zu verstehen, da viele rechtliche Rahmenbedingungen nicht eindeutig sind oder einen Ermessensspielraum und Flexibilität bei ihrer Anwendung zulassen.

Im Rahmen der verschuldensunabhängigen Haftung haften Online-Vermittler für das Fehlverhalten von Nutzenden, ohne dass die Kläger*innen ein Verschulden oder die Kenntnis eines Fehlverhaltens seitens des Vermittlers nachweisen müssen. Da die Haftung auch dann eintreten kann, wenn Vermittelnde absolut nichts falsch gemacht hat, machen die verschuldensunabhängigen Haftungsregelungen die Vermittler übermäßig vorsichtig; sie neigen dazu, die Inhalte der Nutzer*innen generell zu überwachen und ihr Risiko von Ansprüchen zu minimieren, indem sie potenziell rechtswidriges Material „übermäßig“ entfernen. Somit belasten verschuldensunabhängige Haftungsregelungen die Online-Sprache stark, indem sie die Vermittelnden dazu ermutigen, Sprache zu zensieren, selbst wenn sie nicht schädlich ist.

Bei verschuldensabhängigen Ansätzen wird die Haftung auferlegt, wenn vermittelnde Personen oder Plattformen bestimmte „Sorgfaltspflichten“ oder eine bestimmte Sorgfaltspflicht nicht erfüllen. So können Intermediäre beispielsweise verpflichtet sein, bestimmte Arten von Inhalten innerhalb eines bestimmten Zeitraums zu entfernen und/oder ihr (erneutes) Auftauchen zu verhindern. Der britische Gesetzesentwurf zur Online-Sicherheit sieht beispielsweise Sorgfaltspflichten vor, die an bestimmte weit gefasste und potenziell subjektive Vorstellungen von Schaden geknüpft sind, was wiederum Plattformen zu einer allgemeinen Überwachung von Nutzerinhalten verpflichten dürfte. Die auf Fahrlässigkeit basierende Haftung nach dem britischen Modell verfolgt einen systematischen Ansatz bei der Moderation von Inhalten, anstatt sich mit einzelnen Inhalten zu befassen.

Der geforderte Sorgfaltsstandard bei solchen Haftungskonzepten kann auf einem Kontinuum von Fahrlässigkeit (wie sie durch die Handlungen einer vernünftigen Person festgestellt wird) bis hin zu Leichtfertigkeit (eine erhebliche Abweichung vom vernünftigen Handeln) variieren. Verschuldensabhängige Haftungsregelungen erfordern höchstwahrscheinlich ein gewisses Maß an allgemeiner Nutzerüberwachung und können zu einer systematischen Überentfernung von Inhalten oder zur Entfernung von Inhalten führen, die zwar unerwünscht, aber ansonsten völlig legal sind.

Bei wissensbasierten Ansätzen wird die Haftung für rechtsverletzende Inhalte auferlegt, wenn die Vermittler von illegalen Inhalten wissen oder von illegalem Verhalten Kenntnis erlangen. Wissensbasierte Haftungssysteme funktionieren in der Regel über Melde- und Abmeldesysteme und erfordern daher in der Regel keine durchdringende allgemeine Überwachung. Es gibt verschiedene Arten von Benachrichtigungs- und Abmeldesystemen, die unterschiedlich konzipiert sind und unterschiedliche Antworten auf die Frage geben, was eine wirksame Benachrichtigung ausmacht. Auch die Frage, was die Kenntnis des Vermittlers ausmacht, ist wichtig und nicht einfach zu beantworten. Einige Rechtsordnungen verlangen beispielsweise, dass die Rechtswidrigkeit „offenkundig“ sein muss, also für einen Laien erkennbar. Die EU-Richtlinie über den elektronischen Geschäftsverkehr ist ein hervorragendes Beispiel für ein wissensbasiertes System: Vermittler sind von der Haftung befreit, es sei denn, sie wissen von illegalen Inhalten oder Verhaltensweisen und unterlassen es, dagegen vorzugehen. Es kommt also darauf an, was Vermittelnde tatsächlich wissen, und nicht darauf, was ein Anbieter hätte wissen können oder müssen, wie es bei fahrlässigkeitsorientierten Systemen der Fall ist. Der Vorschlag der EU-Kommission für ein Gesetz über digitale Dienste ging jedoch einen Schritt weg vom traditionellen Ansatz der EU, indem er vorsah, dass ordnungsgemäß begründete Hinweise von Nutzer*innen automatisch zu tatsächlicher Kenntnis der gemeldeten Inhalte führen, und somit einen Ansatz der „konstruktiven Kenntnis“ einführte: Bei Plattformanbietern wird gesetzlich unwiderlegbar vermutet, dass sie Kenntnis von den gemeldeten Inhalten haben, unabhängig davon, ob dies tatsächlich der Fall ist. In der abschließenden Einigung einigten sich die Gesetzgebenden darauf, dass es darauf ankommen soll, ob eine Meldung es einem sorgfältigen Anbieter ermöglicht, die Rechtswidrigkeit eines Inhalts ohne eingehende rechtliche Prüfung zu erkennen.

Die Manila-Prinzipien, die von der EFF und anderen NRO entwickelt wurden, betonen die Bedeutung der Existenz eines Gerichtsurteils als globalen Mindeststandard für die Haftungsregeln für Vermittler. Nach diesem Standard kann ein Vermittler nur dann haftbar gemacht werden, wenn das Material vollständig und endgültig als illegal eingestuft wurde und ein Gericht seine Entfernung rechtskräftig angeordnet hat. Es sollte einer unparteiischen Justizbehörde obliegen, festzustellen, dass das fragliche Material rechtswidrig ist. Intermediäre sollten daher nicht den Schutz der Immunität verlieren, wenn sie sich dafür entscheiden, Inhalte nicht zu entfernen, nur weil sie eine private Mitteilung eines Nutzers erhalten haben, oder sie sollten dafür verantwortlich sein, dass sie von der Existenz gerichtlicher Anordnungen wissen, die ihnen nicht vorgelegt wurden oder die sie nicht dazu verpflichten, spezifische Abhilfemaßnahmen zu ergreifen. Nur Anordnungen unabhängiger Gerichte sollten Vermittelnde dazu verpflichten, Inhalte einzuschränken, und jede Haftung, die einem Vermittler auferlegt wird, muss verhältnismäßig sein und in direktem Zusammenhang mit dem rechtswidrigen Verhalten des Vermittlers stehen, der es versäumt hat, der Anordnung zur Einschränkung von Inhalten in angemessener Weise nachzukommen.

Strafliche Immunität für nutzergenerierte Inhalte ist nach wie vor eher unüblich, obwohl sie zu einem verstärkten Schutz der Meinungsäußerung führt. Strafliche Immunität führt dazu, dass die Überwachung von Nutzerinhalten vor der Veröffentlichung nicht stark fördert oder effektiv verlangt wird. Abschnitt 230 ist das deutlichste Beispiel für einen auf Straffreiheit basierenden Ansatz, bei dem Vermittelnde von einer gewissen Haftung für Nutzerinhalte befreit sind – obwohl sich die Straffreiheit nicht auf Verstöße gegen das Bundesstrafrecht, das Recht des geistigen Eigentums oder das Datenschutzrecht für elektronische Kommunikation erstreckt. Abschnitt 230 (47 U.S.C. § 230) ist eines der wichtigsten Gesetze zum Schutz der freien Meinungsäußerung und der Innovation im Internet. Er befreit von der Last der Überwachung vor der Veröffentlichung, die in großem Umfang praktisch unmöglich ist, und ermöglicht so die Existenz von Websites und Diensten, die nutzergenerierte Inhalte – einschließlich kontroverser und politischer Äußerungen – bereitstellen. Abschnitt 230 ermöglicht es den Nutzer*innen, ihre Ideen mit anderen zu teilen, ohne dass sie ihre eigenen Websites oder Dienste einrichten müssen, die wahrscheinlich eine viel geringere Reichweite haben würden.

Die Toolbox zur Haftung der Intermediäre

In der Regel versuchen Gesetze über die Haftung von Vermittelnden, drei Ziele miteinander in Einklang zu bringen: die Verhinderung von Schäden, den Schutz der Meinungsäußerung und den Zugang zu Informationen sowie die Förderung von technischer Innovation und Wirtschaftswachstum. Um diese Ziele zu erreichen, setzt der Gesetzgeber die Hauptbestandteile der Vermittlergesetze auf unterschiedliche Weise zusammen. Diese Komponenten bestehen in der Regel aus: sicheren Häfen (Safe Harbours), Benachrichtigungs- und Takedown-Systemen sowie ordnungsgemäßen Verfahrenspflichten und der Durchsetzung von Nutzungsbedingungen. Wie Daphne Keller hervorhebt, können die Auswirkungen dieser Gesetze durch die Einstellung verschiedener „Regulierungstellschrauben“ gesteuert werden: der Anwendungsbereich des Gesetzes, die Frage, was als Kenntnisnahme gilt, Melde- und Aktionsprozesse und "Guter Samariter“-Klauseln. Darüber hinaus haben einige Regierungen in den letzten Jahren – sehr zu unserer Bestürzung – die Verpflichtungen der Plattformen auf die Überwachung oder Filterung ausgeweitet, obwohl zivilgesellschaftliche Gruppen und Menschenrechtsbeauftragte Bedenken über die daraus resultierenden Gefahren für die Menschenrechte geäußert haben.

Werfen wir nun einen kurzen Blick auf die wichtigsten Instrumente, die den Gesetzgebenden bei der Ausarbeitung von Vorschriften zur Vermittlerhaftung zur Verfügung stehen.

Sichere Häfen bieten Immunität von der Haftung für Nutzerinhalte. Sie sind in der Regel begrenzt und/oder an Bedingungen geknüpft. In den Vereinigten Staaten gilt Abschnitt 230 beispielsweise nicht für die strafrechtliche Haftung auf Bundesebene und für Ansprüche aus dem Bereich des geistigen Eigentums. Der wissensbasierte Ansatz der EU zur Haftung ist ein Beispiel für einen bedingten sicheren Hafen: Wenn die Plattform Kenntnis von illegalen Inhalten erhält, diese aber nicht entfernt, geht die Immunität verloren.

Die meisten Gesetze zur Haftung von Vermittelnden verlangen nicht ausdrücklich, dass Plattformen proaktiv auf verletzende oder illegale Inhalte achten. Die Tatsache, dass Plattformen nicht verpflichtet sind, automatische Filtersysteme einzusetzen oder zu überwachen, was Nutzende online sagen oder teilen, wird als wichtiger Schutz für die Meinungsfreiheit der Nutzenden angesehen. Viele Gesetzesentwürfe schaffen jedoch Anreize für den Einsatz von Filtersystemen, und wir haben in letzter Zeit einige besorgniserregende und umstrittene Gesetzesinitiativen gesehen, die Plattformen dazu verpflichten, systematische Maßnahmen zu ergreifen, um die Verbreitung bestimmter Arten von Inhalten zu verhindern oder proaktiv gegen Inhalte vorzugehen, die wohl einen hohen Wiedererkennungswert haben. Beispiele für solche regulatorischen Maßnahmen werden im dritten Teil dieser Blogserie vorgestellt. Während in einigen Rechtsordnungen Plattformen verpflichtet sind, gegen rechtswidrige Inhalte vorzugehen, sobald sie von deren Existenz Kenntnis erlangen, ist in Rechtsordnungen, in denen der Schutz der Meinungsfreiheit stärker im Vordergrund steht, eine gerichtliche oder behördliche Anordnung zur Entfernung von Inhalten erforderlich.

Intermediäre richten oft ihre eigenen „Melde- und Aktionsverfahren“ ein, wenn das Gesetz keine vollständige Immunität für nutzergenerierte Inhalte vorsieht. Gemäß der EU-Richtlinie über den elektronischen Geschäftsverkehr [sowie Abschnitt 512 des Digital Millennium Copyright Act (DMCA), der sogar ein Melde- und Abmahnverfahren vorsieht] wird von Diensteanbietern erwartet, dass sie mutmaßlich rechtswidrige Inhalte entfernen, sobald sie über deren Existenz informiert werden, um sich im Gegenzug vor bestimmten Formen der Haftung zu schützen. Solche rechtlichen Verpflichtungen gefährden häufig die freie Meinungsäußerung der Nutzer*innen. Die Plattformen neigen dazu, bei solchen Regelungen besonders vorsichtig zu sein, und entfernen häufig völlig legale Inhalte, um eine Haftung zu vermeiden. Es ist viel einfacher und kostengünstiger, auf alle Hinweise zu reagieren, indem man den Inhalt entfernt, als die Ressourcen aufzuwenden, um zu untersuchen, ob der Hinweis gerechtfertigt ist. Die Beurteilung der Rechtmäßigkeit von Inhalten – die oft unklar ist und besondere juristische Kompetenz erfordert – stellt für Plattformen eine große Herausforderung dar.

Vermittelnde üben auch Moderation aus, indem sie ihre eigenen Nutzungsbedingungen und Gemeinschaftsstandards durchsetzen und den Zugang zu Inhalten sperren, die gegen ihre Dienstvereinbarungen verstoßen. Dies wird als „guter Samariter“ betrachtet, der sich um den Aufbau eines gesunden zivilen Umfelds auf den Plattformen bemüht. Dies kann auch Pluralismus und eine Vielfalt von Ansätzen für die Moderation von Inhalten ermöglichen, vorausgesetzt, es herrscht genügend Wettbewerb auf dem Markt für Onlinedienste. Plattformen neigen dazu, ihre Umgebungen so zu gestalten, wie sie die Präferenzen der Nutzer*innen wahrnehmen. Dies könnte bedeuten, dass legale, aber unerwünschte Inhalte entfernt werden oder Inhalte, die nicht mit den erklärten Moralvorstellungen eines Unternehmens übereinstimmen (z. B. Facebooks Verbot von Nacktheit). Da sich der Diskurs in vielen Ländern verschiebt, wird die einflussreiche Rolle, die die dominierenden Plattformen im öffentlichen Leben spielen, anerkannt. Infolgedessen erhalten ihre Nutzungsbedingungen mehr öffentliche und politische Aufmerksamkeit, wobei Länder wie Indien versuchen, die Nutzungsbedingungen von Plattformen über „Sorgfaltspflichten“ zu kontrollieren, und unabhängige Initiativen entstehen, die umfassende Informationen darüber sammeln wollen, wie und warum Social-Media-Plattformen die Beiträge von Nutzer*innen entfernen.

Schließlich können die Auswirkungen von Benachrichtigungs- und Aktionssystemen auf die Menschenrechte der Nutzenden durch Bestimmungen über ein ordnungsgemäßes Verfahren abgeschwächt oder verschärft werden. Verfahrensgarantien und Rechtsbehelfsmechanismen, die in die Benachrichtigungs- und Aktionssysteme der Plattformen integriert sind, können dazu beitragen, die Nutzenden vor irrtümlichen und ungerechten Löschungen von Inhalten zu schützen.

Regulatorische Stellschrauben für politische Entscheidungsträger*innen

Neben der Entwicklung eines Vermittlerhaftungsgesetzes mit den oben beschriebenen Bestandteilen verwenden die Regulierungsbehörden auch verschiedene rechtliche Instrumente, um die Wirkung des Gesetzes nach Belieben anzupassen.

Umfang

Der Anwendungsbereich von Gesetzen zur Vermittlerhaftung kann sehr unterschiedlich sein. Der Geltungsbereich kann eingegrenzt oder erweitert werden, um beispielsweise Diensteanbieter auf der Anwendungsebene (wie Social-Media-Plattformen) oder auch Internetzugangsanbieter einzubeziehen.

Intervention bei Inhaltsvermittlung

Verliert eine Plattform ihre Immunität, wenn sie in die Versendung von Inhalten eingreift, z. B. durch algorithmische Empfehlungen? In den USA behalten die Plattformen ihre Immunität, wenn sie sich dafür entscheiden, Inhalte zu kuratieren oder zu moderieren. In der Europäischen Union ist die Situation weniger klar. Zu viele Eingriffe können als Wissensvermittlung angesehen werden und könnten dazu führen, dass Plattformen ihre Immunität verlieren.

Wissen

Bei wissensbasierten Haftungsmodellen ist ein sicherer Hafen an die Kenntnis der Vermittelnden von rechtsverletzenden Inhalten gebunden. Was als tatsächliche Kenntnis gilt, ist daher ein wichtiges Regulierungsinstrument. Wann kann davon ausgegangen werden, dass ein Diensteanbieter von illegalen Inhalten weiß? Nach einer Benachrichtigung durch einen Nutzenden? Nach einer Benachrichtigung durch eine vertrauenswürdige Quelle? Nach einer gerichtlichen Unterlassungsverfügung? Breite und enge Definitionen des Begriffs „Kenntnis“ können sehr unterschiedliche Auswirkungen auf die Entfernung von Inhalten und die Zuweisung der Haftung haben.

Regeln für Bekanntmachung und Maßnahmen

In Rechtsordnungen, die Melde- und Aktionsregelungen vorsehen oder vorschreiben, ist es von entscheidender Bedeutung, ob die Einzelheiten eines solchen Mechanismus gesetzlich geregelt sind. Ist das Verfahren, nach dem Inhalte entfernt werden können, eng definiert oder bleibt es den Plattformen überlassen? Sieht das Gesetz detaillierte Schutzmaßnahmen und Rechtsbehelfsmöglichkeiten vor? Unterschiedliche Herangehensweisen an diese Fragen werden zu einer sehr unterschiedlichen Anwendung der Vorschriften für Intermediäre und damit zu sehr unterschiedlichen Auswirkungen auf die Meinungsfreiheit der Nutzenden führen.

In der nächsten Folge werden wir uns mit den jüngsten Entwicklungen und Regulierungsvorschlägen aus der ganzen Welt befassen. Die anderen Blogs in dieser Reihe finden Sie hier:

Erster Teil: Von sicheren Häfen zu erhöhter Haftung

Dritter Teil: Plattformhaftungstrends rund um den Globus: Jüngste bemerkenswerte Entwicklungen